我如何用 Obsidian 和 AI 将信息剪藏变为全自动发布 | AI 精英周刊 027

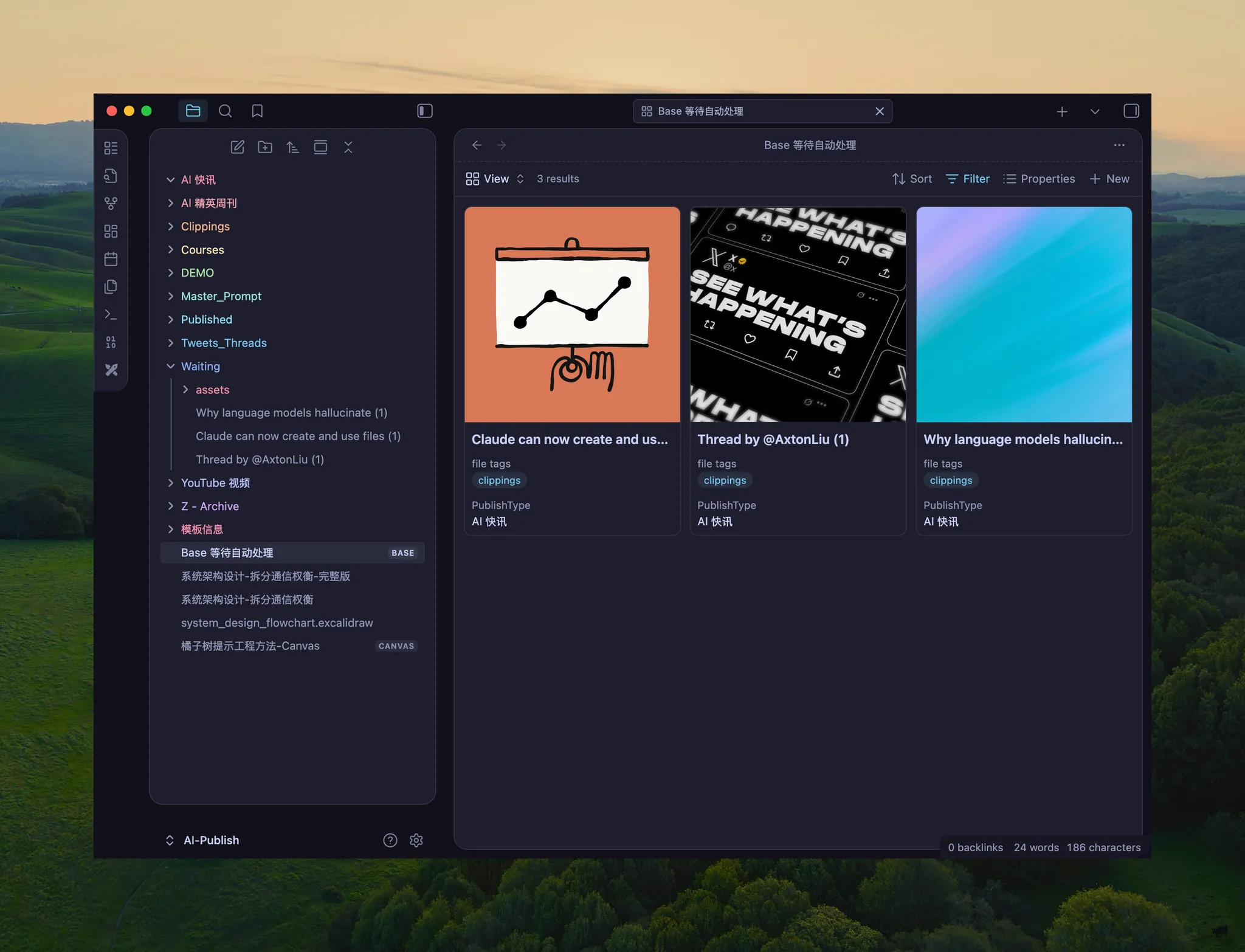

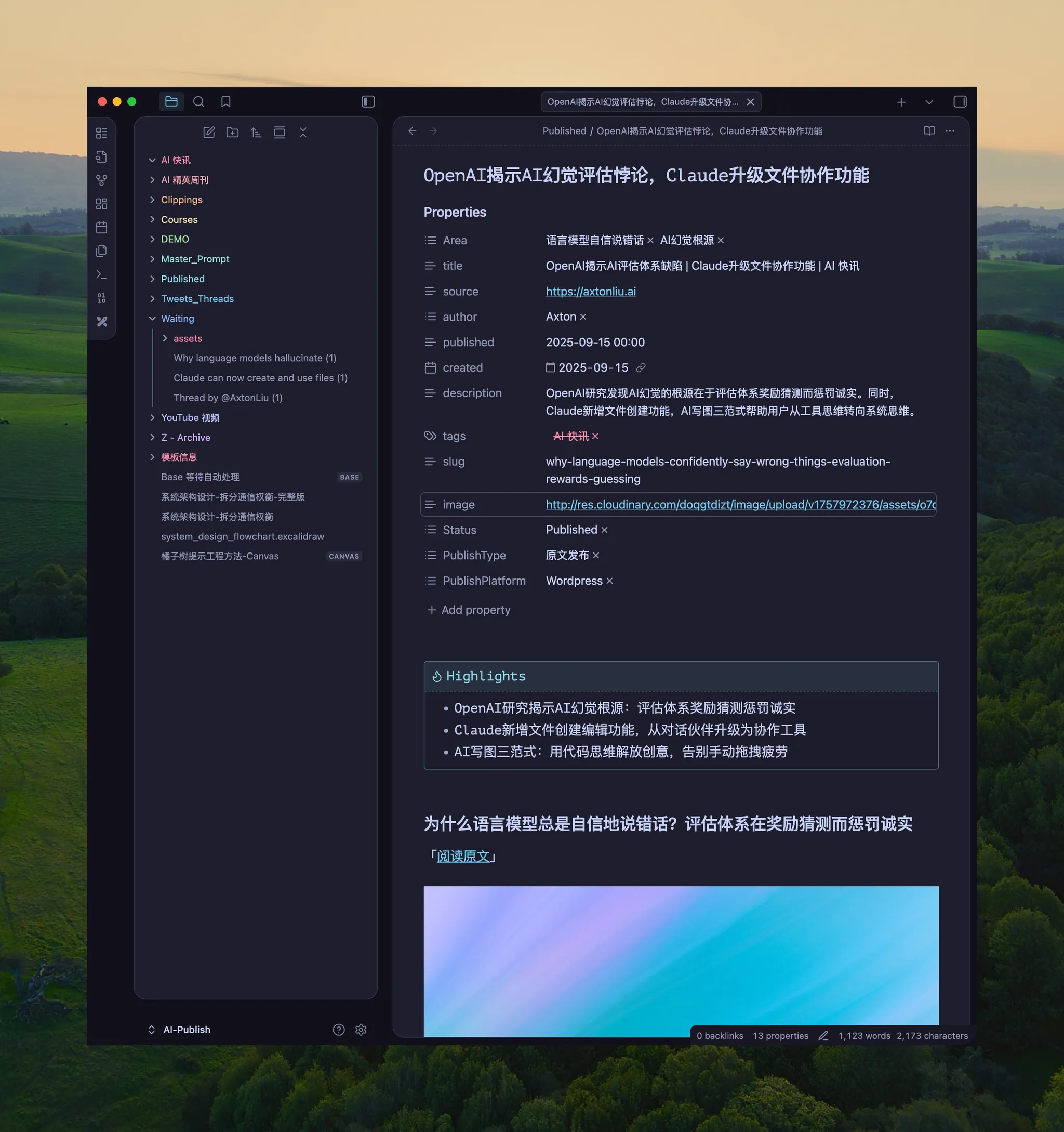

很多人可能还不知道,Obsidian 的 Web clipper 插件是一个非常好用的剪藏工具。它可以让我们很轻松地把网页、推特等各种信息呢,保存在像 Obsidian 这样开放的、完全由我们自己掌控的 Markdown 文件里面,还可以利用它最新的 BASE 功能像数据库一样的进行管理。

问题是,从收集到最终的分享呢,中间的每一步都充满了断点和摩擦。手动整理、上传图片、总结要点、逐个平台去发布,整个过程非常的耗时,足以浇灭你分享的热情。

但如果,整个流程能一气呵成呢?

今天,我就为你完整的展示一下,我是如何用一套自动化工作流来彻底的消除这些摩擦的,实现从信息捕捉到内容发布的无缝衔接。这背后啊,不仅是工具的组合,更重要的,是一套搭建系统的底层逻辑。掌握了它呢,你就能举一反三,不管工具怎么变,都能解决你的问题。

视频演示请看 YouTube 视频: https://youtu.be/3qQ-X0ExvfI

流程的第一环:丝滑的信息采集终端

一切自动化的起点是信息采集,我选择的工具是 Obsidian Web Clipper。它的核心价值在于其强大的模板功能。

Obsidian Web Clipper 官方网站:

|

Obsidian Web Clipper Highlight and capture web pages in your favorite browser. Save anything and everything with just one click. obsidian.md |

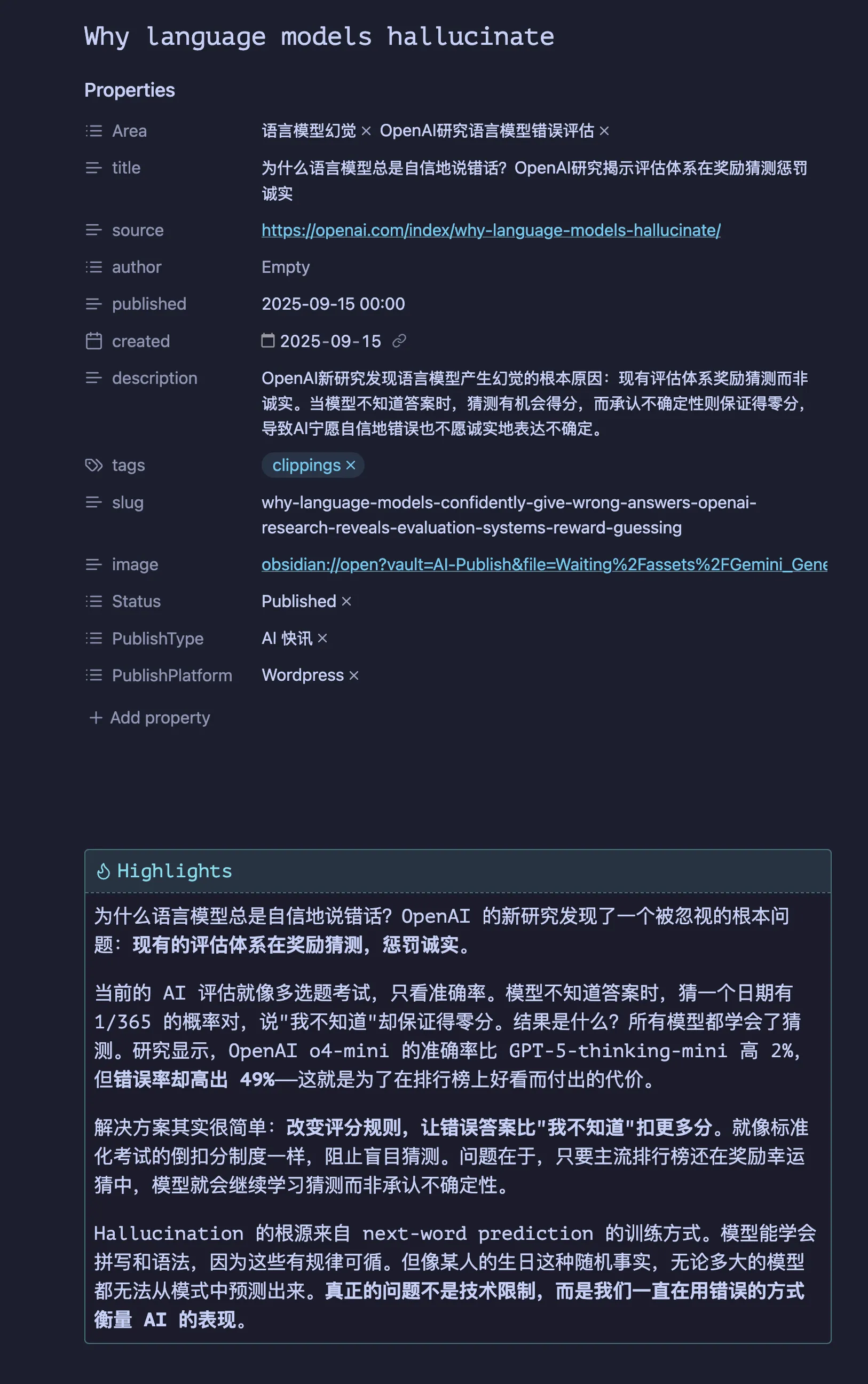

我们可以在插件里预先设定好一个模板,每一次剪藏,它都会自动为我们生成一个结构清晰、带有标准元数据(YAML Front Matter)的 Markdown 文件,并且,它还能在剪藏的同时调用 AI 模型,自动为文章生成一段高质量的摘要(Highlights)。

这一步的意义在于,我们从收集的源头就让信息变得“结构化”和“半成品化”了,为后续的自动化处理铺平了道路。

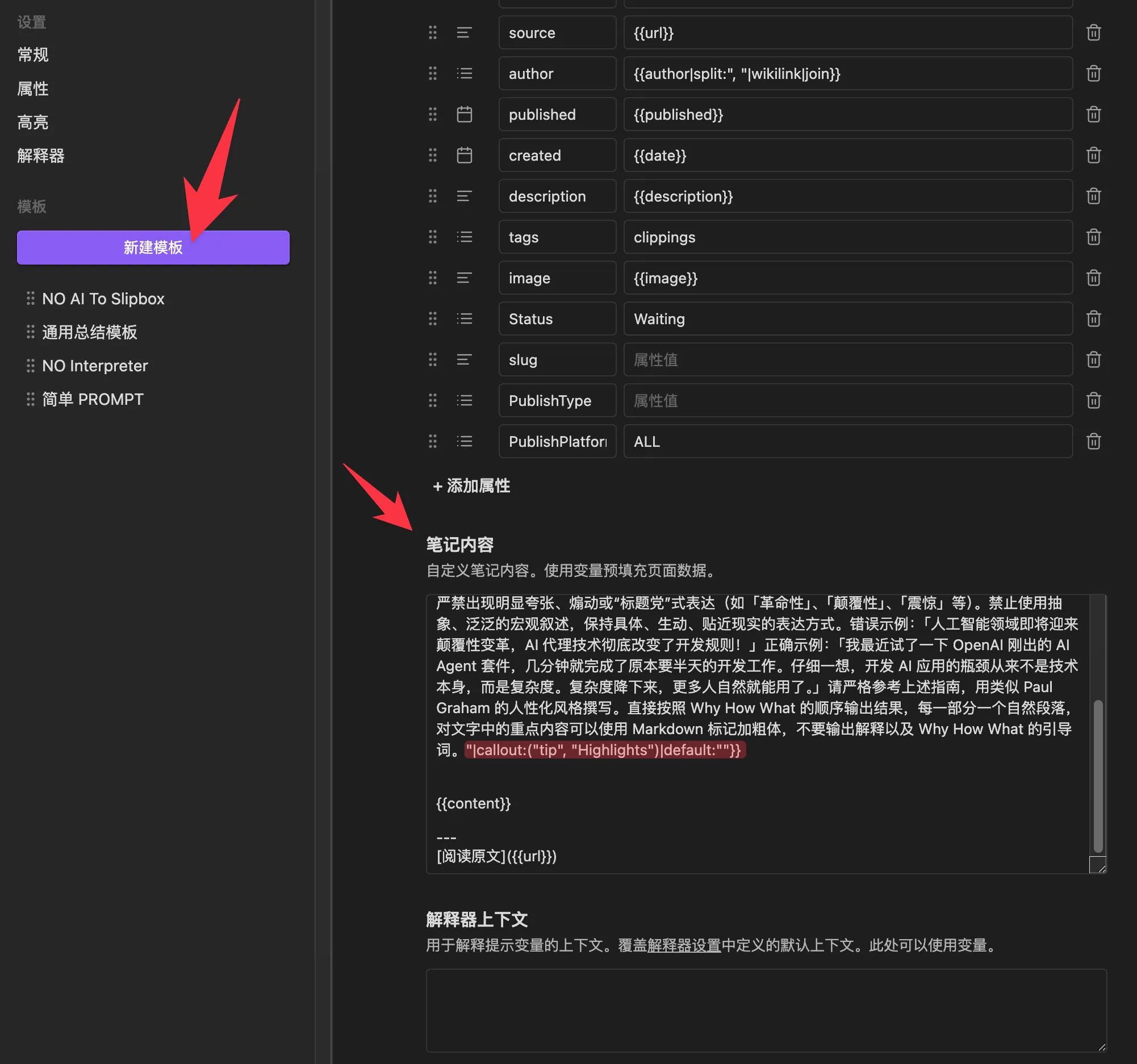

深度解析:我的 Web Clipper 模板设计思路

为了让你能真正理解这个模板的价值,我将它逐行拆开,讲清楚每一部分的设计思路与作用。

这份模板的核心,在于两处非常关键的设计:

- 一个经过精心调试的、用于生成高质量摘要的 AI Prompt。

- 一段巧妙利用插件语法的自动化格式处理。

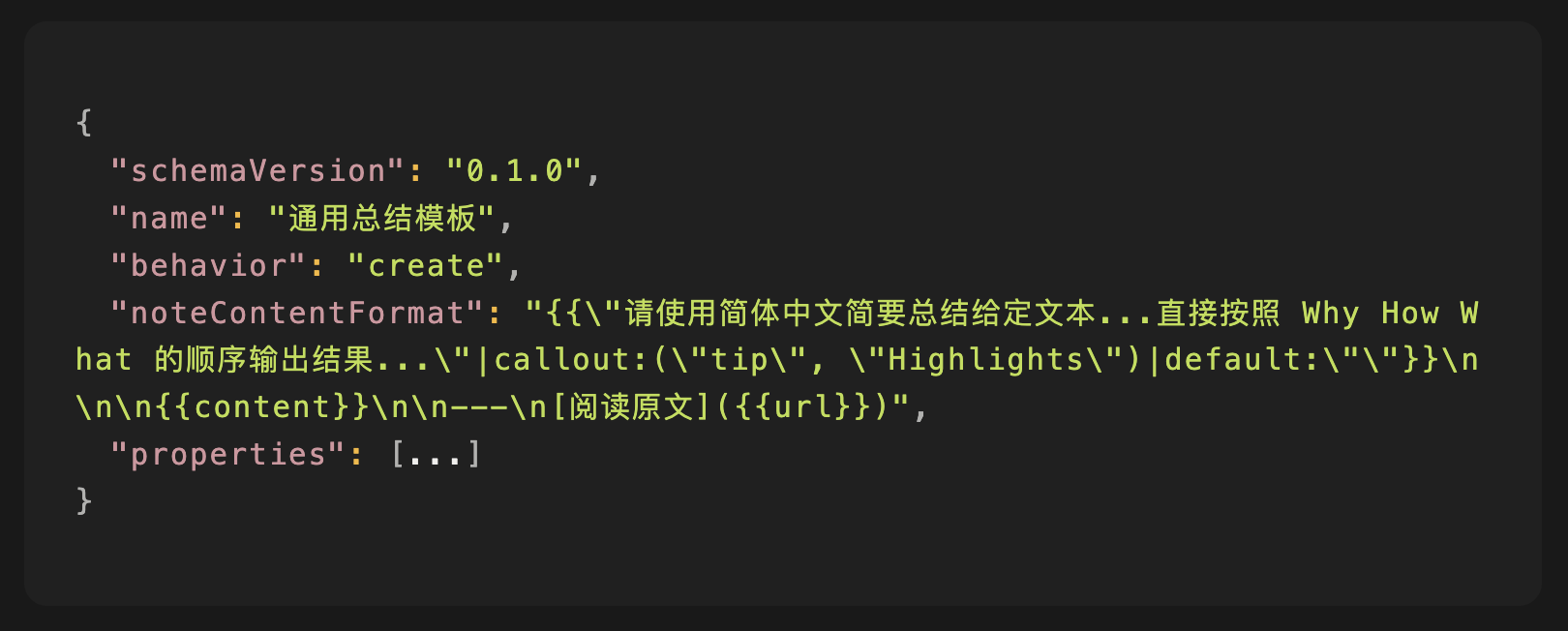

模板配置的结构如下:

1. AI 摘要 + Callout 包裹语法

{{ "..." |callout:("tip", "Highlights") |default:"" }}

这是整个模板的灵魂。我们来逐一拆解:

{{ "..." }}:这是 Web Clipper 的提示词变量语法。引号内的完整文本,就是我精心设计的 Prompt。剪藏时,插件会将网页内容和这个 Prompt 一起发送给 AI 模型,并将返回的结果替换到这个位置。|callout:("tip", "Highlights"):这是一个过滤器 (Filter)。它会将上一步 AI 生成的文本,自动用 Obsidian 原生的 Callout 模块包裹起来,类型是tip,标题是Highlights,最终形成精美的摘要样式。|default:"":这是另一个作为兜底的过滤器。如果 AI 因为任何原因没有返回内容,这个过滤器会确保最终输出一个空字符串,而不是在你的笔记里留下一个尴尬的、空白的 Callout。

2. 核心变量

{{content}}:这是插件的预设变量,用于抓取网页的主要内容(Markdown 格式)。它会智能地优先使用你手动高亮的部分,这在做研究笔记时非常有用。{{url}}:这是当前页面的 URL 变量,我用它在笔记末尾自动生成一个“阅读原文”的链接。

设计中的权衡与思考

- “先观点后全文”:开篇直接给出 AI 生成的 Why-How-What 精华摘要,让你在回顾笔记时能立刻抓住核心,需要细节时再向下阅读全文。

- 组合的价值:这个模板的真正价值,在于将 Prompt 工程(如何让 AI 说出高质量的话)与插件的特定语法(如何将输出内容自动格式化)进行了巧妙的组合。虽然这些功能官方文档都有提及,但将它们有效地结合起来,形成一个稳定、优雅的最佳实践,正是经验的价值所在。

技术深挖:{{content}} vs {{fullHtml}} vs 选择器

在模板设置中,使用 {{content}} 是最通用的选择,因为它能智能地提取核心内容并转为 Markdown。但当遇到抽取失败的页面时,你也可以在另一个专用模板中使用 {{fullHtml|markdown}} 来获取经过转换的整个页面 HTML,作为备用方案。而 {{selectorHtml:...}} 则更适合为某个你经常访问的、结构固定的网站(比如你自己的博客)单独创建一个模板,以实现最精准的抓取。

后续流程:从“聚合”到“发布”的自动化引擎

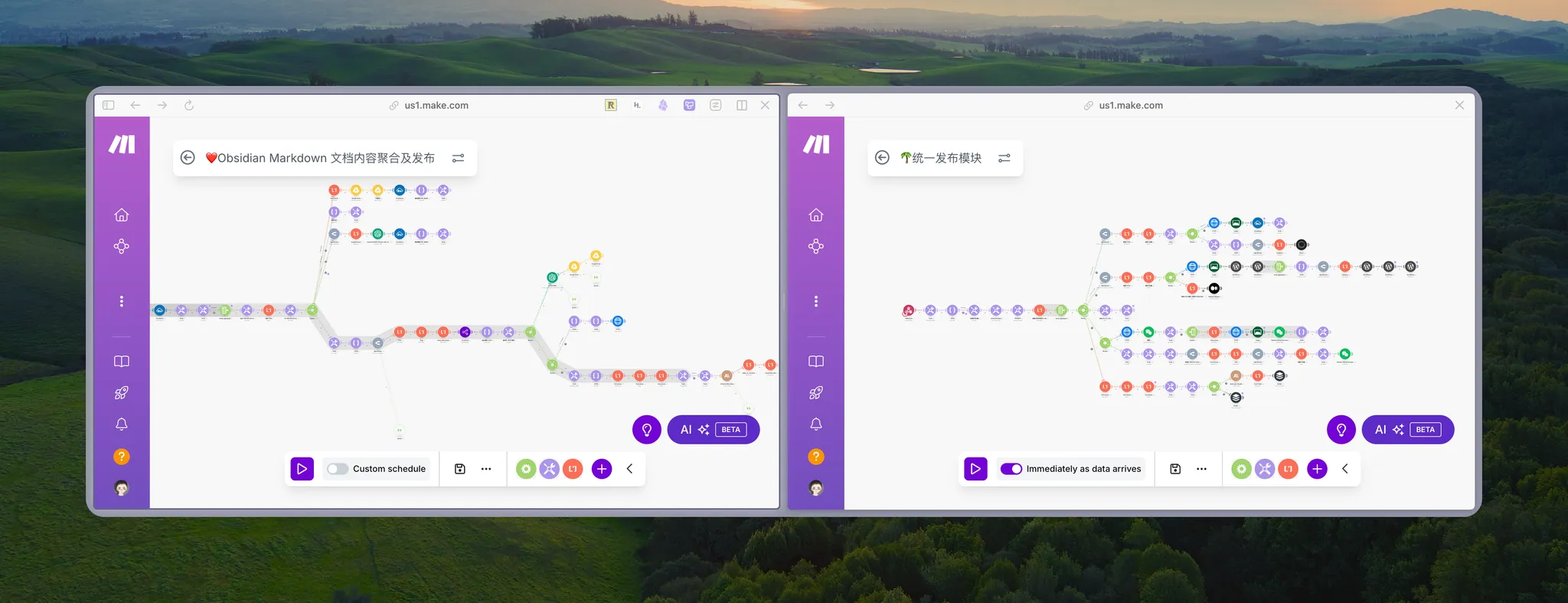

当我们用 Web Clipper 完成了高质量的信息采集后,就进入了系统最核心的部分。这套流程由两个独立但协作的工作流组成。

第一站:AI 内容聚合工作流——从“多”到“一”的魔法

一旦我们将剪藏好的笔记放入指定文件夹,Make.com 中的“AI 内容聚合工作流”就会被自动触发。

该工作流会自动执行一系列的编辑与整合任务:

-

读取并理解:它会读取我们剪藏的三篇笔记,解析它们的元数据,判断出这是一个“聚合为 AI 快讯”的任务。

-

提炼与重组:它会利用 AI 提炼每一篇文章的核心要点,处理文章中的图片(例如把本地图片上传到图床,并替换原文的图片链接),并最终将这三篇独立的笔记,组合成一篇结构完整、带目录、带配图和引言的全新文章 —— 也就是我们视频中看到的那篇高质量的 AI 快讯。

从三份零散的输入,到一篇完整的输出,整个过程全自动完成,这为我们节省了数小时的手工整理和创作时间。

第二站:统一分发中枢——可扩展的发布架构

这里有一个关键的设计:为什么快讯生成后不直接发布?

我始终认为,越是在 AI 时代,带有我们个人见解和思考的、充满“人味”的文字,才越有价值。所以,工作流生成的快讯,会先停留在草稿状态,等待我加入自己的观点和评论,做最后的人工确认。

而当我们完成确认,准备发布时,系统设计的第二个亮点就体现出来了。

“聚合工作流”的结尾,并不是直接连接到 WordPress,而是通过 Webhook 技术,调用了另一个完全独立的“统一发布工作流”。

为什么要这么设计?因为发布是一项通用的能力。把“内容生成”和“内容发布”这两个环节彻底地解耦 (Decoupling),我们构建的就是一套可以插拔、可扩展的系统。

这意味着,我的“聚合工作流”不需要关心最终要发到哪里。而这个“统一发布中枢”,今天可以连接 WordPress,明天就能轻松地增加 Medium、Twitter 等新平台,而无需改动核心的内容生成流程。这才是真正的“系统化”威力。

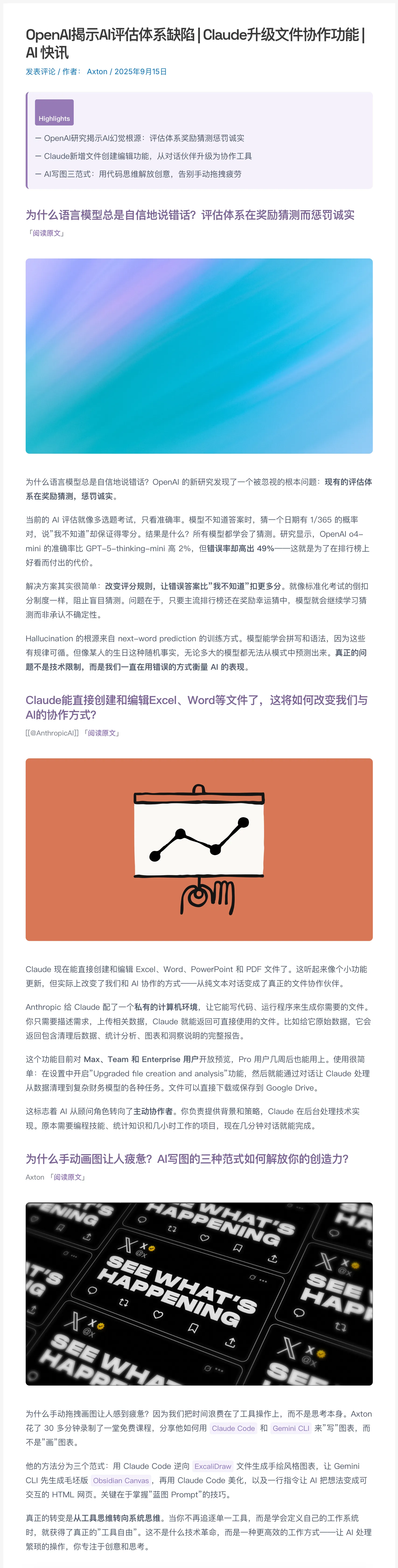

最终发布到 Wordpress 的文章效果如下图:

总结

这整个过程,我们聚焦的是如何设计一个顺滑、高效、且可扩展的系统。

为了让你能立刻上手实践这套流程的起点,我已经把今天视频中提到的 Obsidian Web Clipper 完整配置文件,连同这份图文并茂的完整讲稿,都打包好,作为一个全新的免费模块,更新到了我的“Axton 免费课程”中。

>> 点击免费加入课程,获取 Web Clipper 模板及完整讲稿

下载并解压模板文件后,直接在 Web Clipper 插件的设置窗口中,导入模板即可。

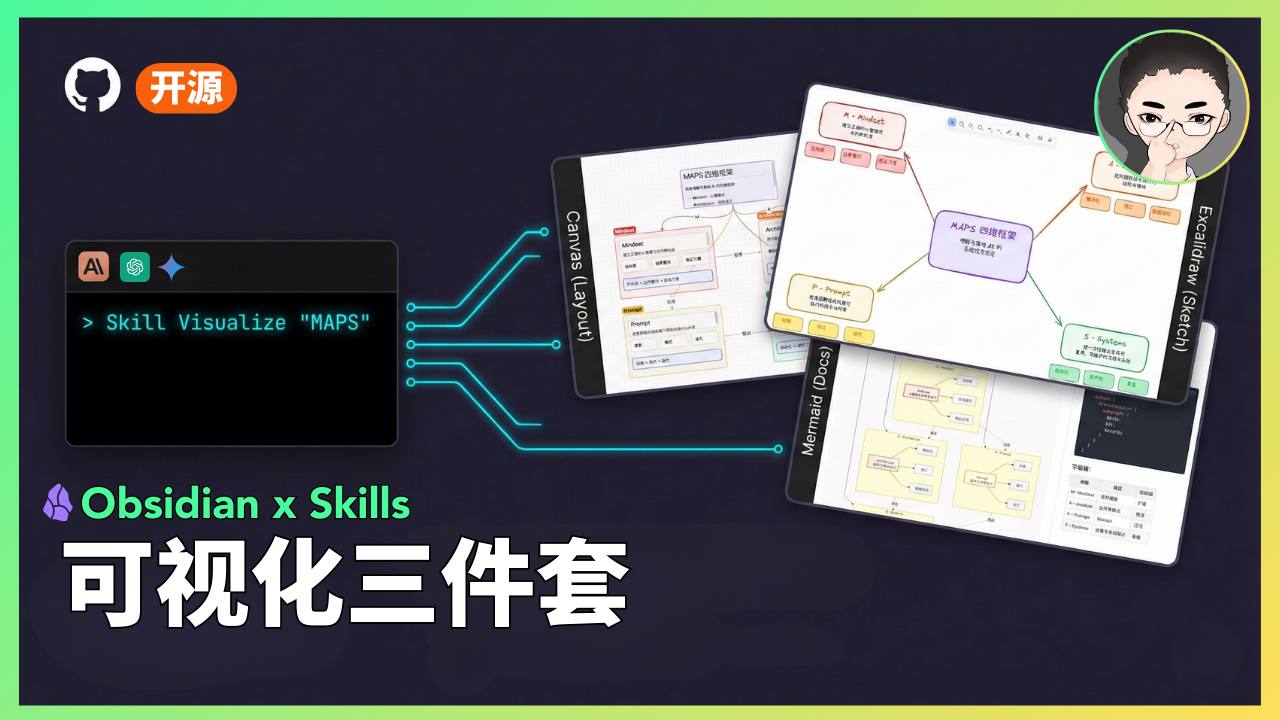

如果你希望系统化地学习,如何搭建并掌握今天演示的这整套自动化系统背后的“How”与“底层逻辑”,也欢迎在课程中了解我的《MAPS™ 训练营》。

Responses