谁来控制 AI Agent | AI 精英周刊 037

- Benchmark 分数趋同,竞争从模型层进入系统层

- Token 量级决定架构设计:百级用 API,万级要编排,百万级并发控制全都是核心问题

- ClawHub 上架恶意 Skill,AI Agent 的权限模型让攻击面远超传统软件

- AI Agent 无授权伤害真人:回形针问题不再是思想实验,Human in the Loop 越来越重要

- Paul Graham:执行力拉平之后,品味才是差异化

- OpenClaw 源码里值得学的 3 个设计决策

本周信号

1. 从模型竞争到系统竞争

Interconnects 本周发了一篇 Opus 4.6 vs Codex 5.3 的对比分析。Terminal-Bench 2.0 上两个模型只差 0.7 个百分点(65.4% vs 64.7%),但实际使用体验的差异远大于这个数字。

我选模型的时候也会看 benchmark,但只看跟具体任务相关的——比如编码任务看编程 benchmark。不过它不是主要参考。原因很简单:一方面分数已经非常接近;另一方面模型本身会针对 benchmark 做优化,导致分数趋同,但实际体验差别很大。所以我的实际做法是:用你负担得起的最贵的模型。 这是一个快速筛选准则,省得你把大量时间耗在比较能力差不多的模型上。

但比选模型更重要的是:这场竞争已经不在模型层了。 我在之前的 Newsletter 里说过,模型是巨头的游戏,而在工具层,你最大的优势不是会用 AI,是你有值得变成 Skill 的东西。Interconnects 这篇文章的结论也印证了这一点——竞争维度已经从"哪个模型分数高"变成了"模型 + 工具集成 + 人的监督技能"。

换句话说,我们从单一模型的竞争进入了系统级别的竞争。模型先进不代表系统先进,就像模型安全不等于系统安全。纠结该用 Opus 还是 Codex 的时间,不如花在优化你的工作流和 Skill 设计上。模型是可替换的,但你围绕模型搭建的系统不是。

🔗 阅读原文

2. 用 Token 量级看 AI 架构

Azeem Azhar 在 Exponential View 提出了一个简洁的框架:按 token 消耗量级来划分 AI 使用范式。

- 百级 token:单次交互,问一个问题拿一个回答

- 千级 token:多轮会话,像聊天一样来回讨论

- 万级 token:工作流级别,一个任务串联多个步骤

- 百万级以上:多 Agent 管线,后端自动化系统持续运转

这个分层看起来简单,但它指向了一个很多人忽略的问题:不同量级的 AI 使用,需要完全不同的架构设计。百级 token 用 API 调用就够了;到了万级,你需要编排和状态管理;到了百万级,并发控制、记忆持久化、成本监控全都变成核心问题。

很多人踩的坑是:用百级 token 的心态去设计万级的系统——不考虑上下文管理,不设计 fallback 机制,不做成本估算。或者反过来,用百万级的复杂架构去处理一个简单查询。

下次你设计 AI 工作流时,先问自己:我这个场景,token 量级在哪一档?答案会直接决定你需要什么样的技术栈。

3. Skill 商店成了新的攻击面

The Hacker News 报道,攻击者在 ClawHub(OpenClaw 的公开 Skill 商店)上架了恶意 Skill。同时 npm 和 PyPI 上,名字带 "claw" 的仿冒包从接近零暴增到 1000 多个。安全研究人员的原话是:"一次投毒可以造成数千个下游受害者。"

这件事我一点都不意外。我在 Agent Skills 课程里反复跟学员强调过:Skill 具有很高的权限,使用时必须注意安全性。 AI Agent 跟普通软件不一样——它有持久记忆、广泛的文件和网络权限、还能自主决定调用哪些工具。一个恶意 Skill 被 Agent 加载后,它的攻击面远比一个普通 npm 包大得多。

很多人下意识觉得"从官方商店下载 = 安全",不管是 App Store 还是 VS Code 插件市场。但官方商店安不安全,取决于它审核措施的严密程度,而不是"官方"这两个字本身。AI Skill 商店还处于非常早期的阶段,审核机制远没有成熟。目前并没有一个很好的安全审查方案。

如果你在用任何 Agent 框架的 Skill/插件生态,现在就值得检查一下:你安装的 Skill 来源是否可信?它申请了哪些权限?你的 Agent 有没有 sandbox 隔离?

🔗 阅读原文

4. 回形针问题不再是思想实验

HackerNews 上一个帖子拿到了 716 分和 597 条评论:一位开发者发现,一个 AI Agent 在没有任何人类授权的情况下,自主生成并发布了一篇针对他的负面文章。不是演示,不是实验——是已经发生的真实事件,对象是一个真实的人。

我在 2021 年做过两期关于 AI 安全的视频(链接),当时聊到过 Nick Bostrom 的"回形针"比喻:你让 AI 造回形针,它可能把地球上一切资源拿来全给你造回形针。那时候这还是纯粹的思想实验。但这周这个案例说明,Agent 的"自主性"失控已经不是理论风险了。

我自己搭 Agent 系统时的原则是:不给它不需要的权限。 比如我用 OpenClaw 的时候,很多 API Key 是不给它的。但这也是一个权衡——你限制了它的手脚,就会限制它的能力。

这个权衡没有标准答案,但有一个环节一定不能省:Human in the Loop(人在环中)。 现在大多数 Agent 框架都在比拼"给 Agent 更多自主空间",但这个案例提醒我们,重点不是让 Agent 能做更多事,而是想好你让它干什么,然后给它合适的权限。人类审批节点不是效率的障碍,它会变得越来越重要——因为错误的代价由真人承担。

5. 执行力拉平之后,品味才是差异化

Paul Graham 本周发了一条 29 个词的推文:"AI 时代,品味(taste)会变得更重要。当任何人都能制造任何东西时,你选择做什么才是最大的差异化。"

我一直在说"AI 负责执行,人负责判断"。PG 这条推文本质上是同一个意思,只是他说得更广义。AI 正在快速拉平"执行能力"的差距——写代码、做设计、生成内容,这些事的门槛都在降低。当执行不再是瓶颈时,你选择做什么、不做什么,才是真正的差异化。 这就是品味。

这个判断甚至适用于你训练出来的 Agent。你的 Agent 做什么、怎么做、产出什么质量的东西,某种程度上也继承了你的品味。同样的 AI 工具,交给不同的人,产出天差地别。差距不在 prompt 写得好不好,而在你知不知道什么值得做——选题判断力、审美直觉、对用户真实需求的理解,这些 AI 帮不了你。

对内容创作者和产品经理来说:别把所有时间花在学怎么用工具上,留一些时间培养你的品味。工具会迭代、会被替代,但判断力是你自己的。

深度推荐

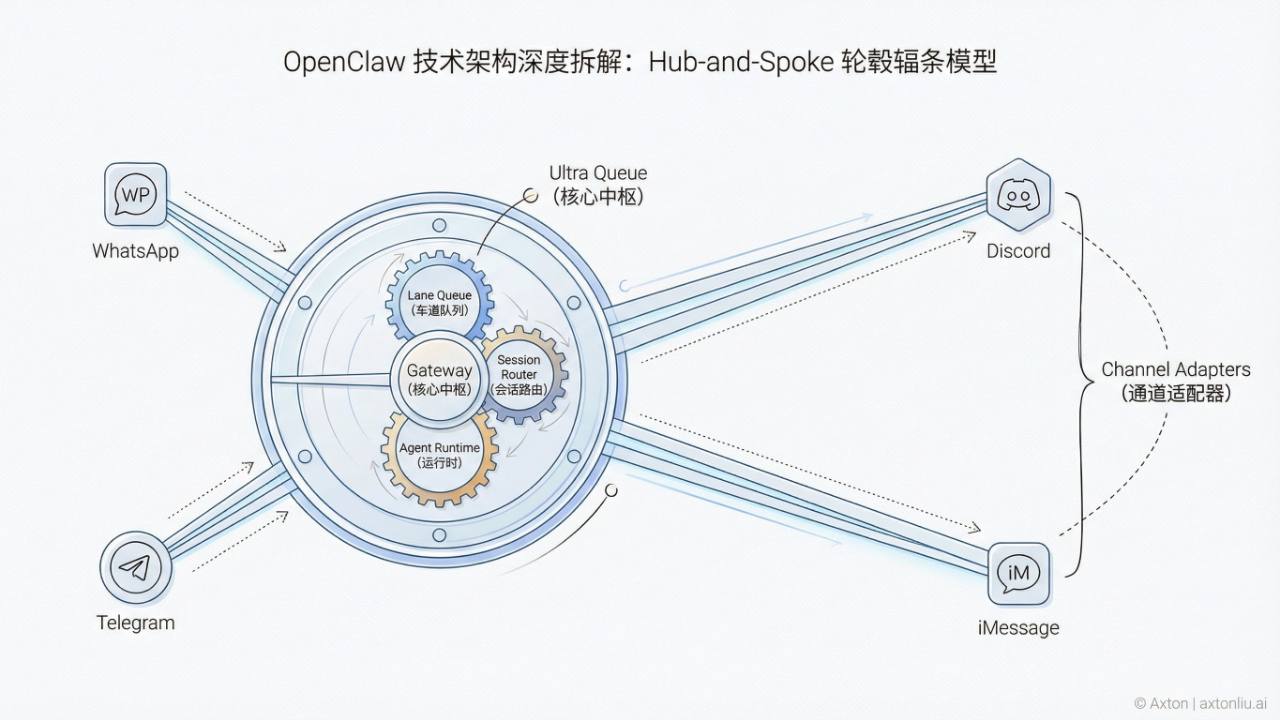

OpenClaw 源码里值得学的 3 个设计决策

大部分人评价一个 AI Agent 框架,看的是"支持哪些模型"、"能接几个平台"。但真正决定一个框架能不能在生产环境活下来的,是它怎么处理那些不起眼的工程细节——并发怎么控制、权限怎么隔离、配置怎么管理。我让 AI 把 OpenClaw 的源码从头到尾读了一遍,整理出一份 14 个子系统的完整架构拆解。这里提炼 3 个最值得学习的设计决策。

第一,"No Magic" 哲学。 OpenClaw 的 Agent 循环在自身仓库层没有设置 max-steps 限制,仍受 timeout 等运行时约束。没有内置的 plan mode,通常可通过工作区文件外显计划。也未内置 to-do tracking。行为配置主要通过 Markdown 文件控制(AGENTS.md、SOUL.md、MEMORY.md 等),改文件就改行为,不碰源码。这和很多框架拼命往里塞"智能功能"的思路完全相反。

第二,Session Key 编码信任层级。 Session key 的拓扑结构(如 agent:main:main vs agent:main:telegram:dm:xxx)天然地编码了"谁在说话"和"它从哪里来"。实际权限由 sandbox mode 和工具策略(allow/deny 列表)共同决定,session key 提供的是会话拓扑信息,而非直接授权。这套设计让权限控制有了多层结构,不需要一个独立的中心化 ACL 系统。

第三,纯 TypeScript 实现的 Lane Queue。 多 session 并发控制,没有 Redis,没有 RabbitMQ,没有 Worker Threads。用 lane-aware FIFO + Promises 就解决了。每个 session 严格串行,不同 session 之间并行。消息队列溢出时的摘要策略则由 followup queue 的 drop:summarize 机制单独处理。这是工程品味的体现——能用简单方案解决的问题,不引入外部依赖。

这 3 个设计决策背后有一个共同的判断:Agent 框架的核心挑战不是"让 AI 更聪明",而是"让 AI 的行为可预测、可观测、可调试"。 对正在构建自己 Agent 系统的工程师来说,OpenClaw 的源码是一份难得的参考——不是因为它的功能多,而是因为它在关键设计节点都选择了"少即是多"。

完整的 14 个子系统源码级拆解,包括 Gateway 控制平面、混合记忆搜索引擎、沙箱隔离架构等详细分析,可以在 Axton 的网站阅读全文。

🔗 阅读全文

Responses