揭秘不同AI的“文风”偏好:你的Prompt风格选对了吗? | AI 精英周刊 022

你是否注意到,和不同AI模型(比如Claude、GPT系列)打交道时,它们似乎对Prompt的”写法”有着不同的偏好?Claude偏爱有序列表和XML标签,GPT时常用分隔线和括号,而OpenAI Playground的生成器则钟情于Markdown标题。

这仅仅是不同厂商的”风格差异”吗?还是说,这些写法真的会影响AI的输出效果?今天,我们就来深入探讨这个话题。

AI Prompt的”三大流派”及其特点

让我们先直观感受一下这些不同风格的Prompt:

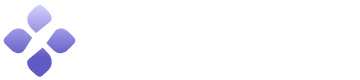

Claude风格:有序列表 + XML标签

Claude倾向于接收用XML标签包裹指令和上下文的Prompt。这种结构清晰,指令层级分明。比如以下的 PROMPT 片段:

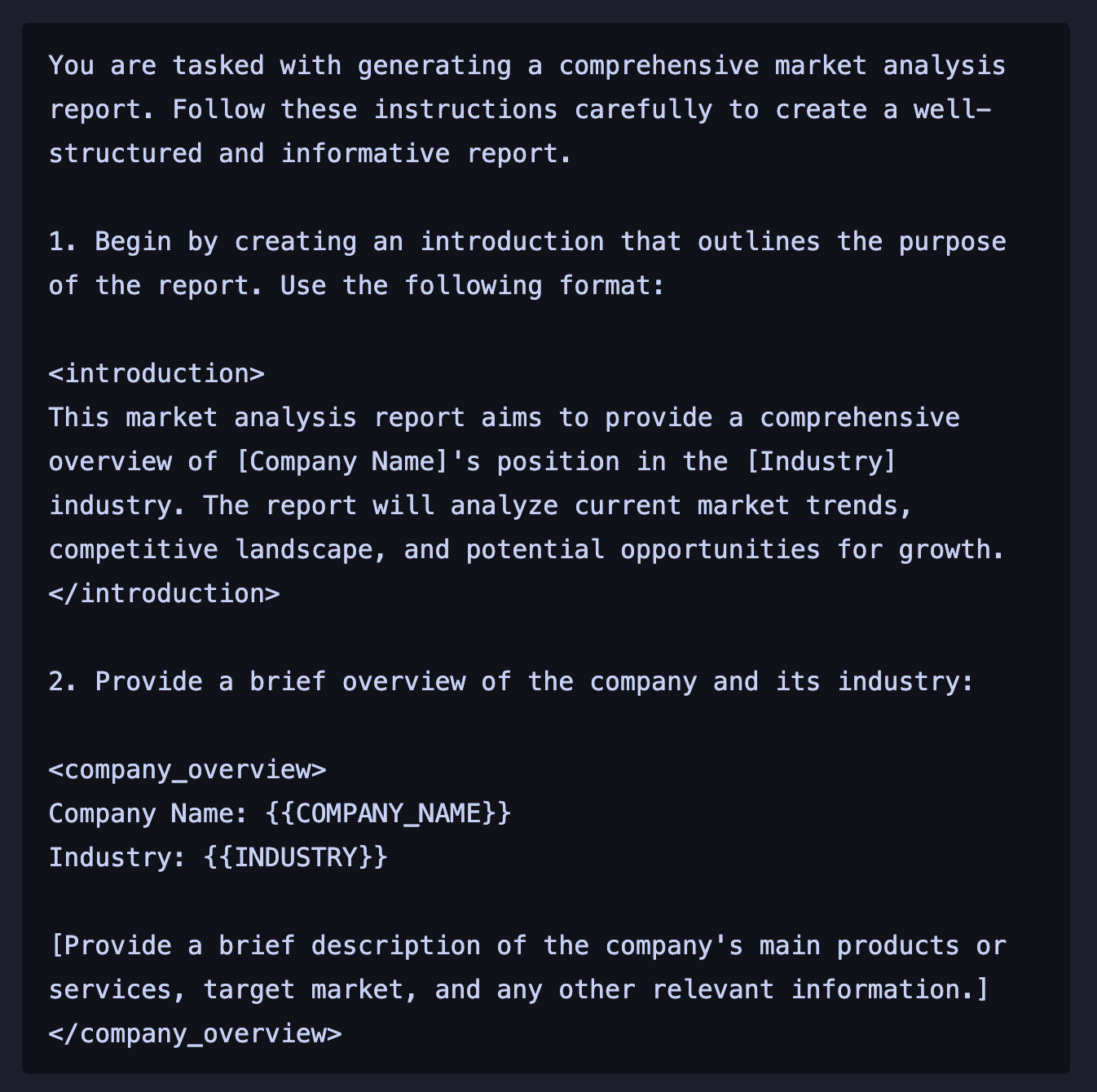

GPT (o3)风格:连续分隔线 + 特殊括号

如果我们直接在 ChatGPT 中,选择用 o3 模型帮忙写 PROMPT,那么它一般会使用连续的短横线、等号线作为段落分隔,并用中括号或尖括号来区分不同的输入区域或指令部分。

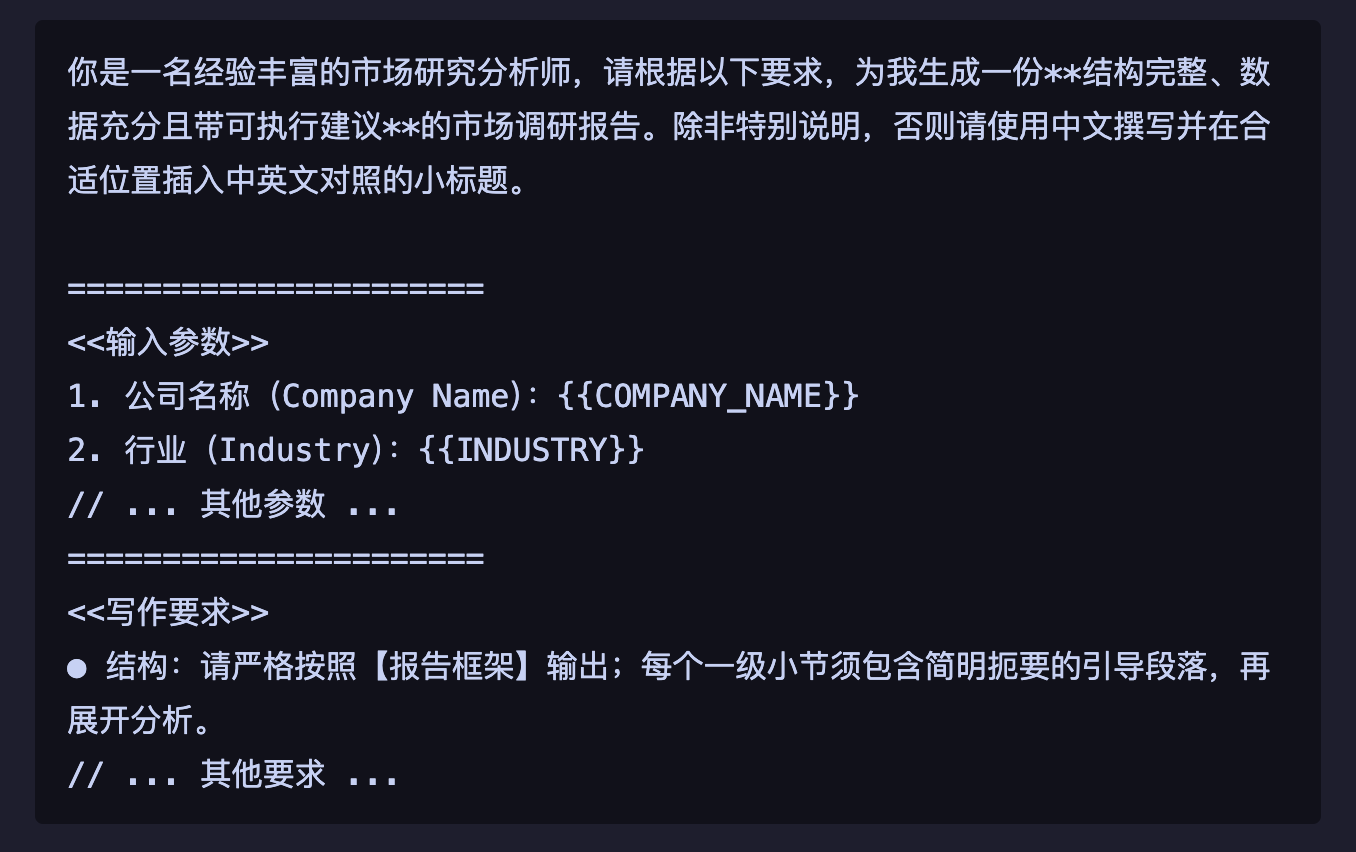

OpenAI Playground / ChatGPT风格:Markdown标题 + 粗体/列表

这种风格大家可能最熟悉,OpenAI Playground 自动生成的 Prompt 以及 ChatGPT 通常情况下的输出,经常采用Markdown的#号标题来区分章节,用粗体和有序/无序列表来细化任务。

辅助工具:官方Prompt生成器与优化器一览

了解了这些主流风格后,你可能会想,如何才能高效地写出或者优化出这类专业的 Prompt 呢?自然是使用 OpenAI 和 Claude 官方提供的提示词生成工具。

- Claude 的 Prompt利器:生成与优化双管齐下 我个人非常喜欢使用 Claude 的 Prompt 生成器来帮助构建结构清晰、专业的Prompt。Anthropic 在 Claude 的控制台页面(Console)非常贴心地提供了一个效果出色的 Prompt 生成器 (Prompt Generator)。你只需要用自然语言描述你的目标和需求,它就能帮你生成一个符合Claude偏好的、带有XML标签结构的初始Prompt。更棒的是,它还有一个优化器 (Optimizer) 功能,可以针对你现有的Prompt提出改进建议,帮助你进一步提升Prompt质量和模型输出效果。

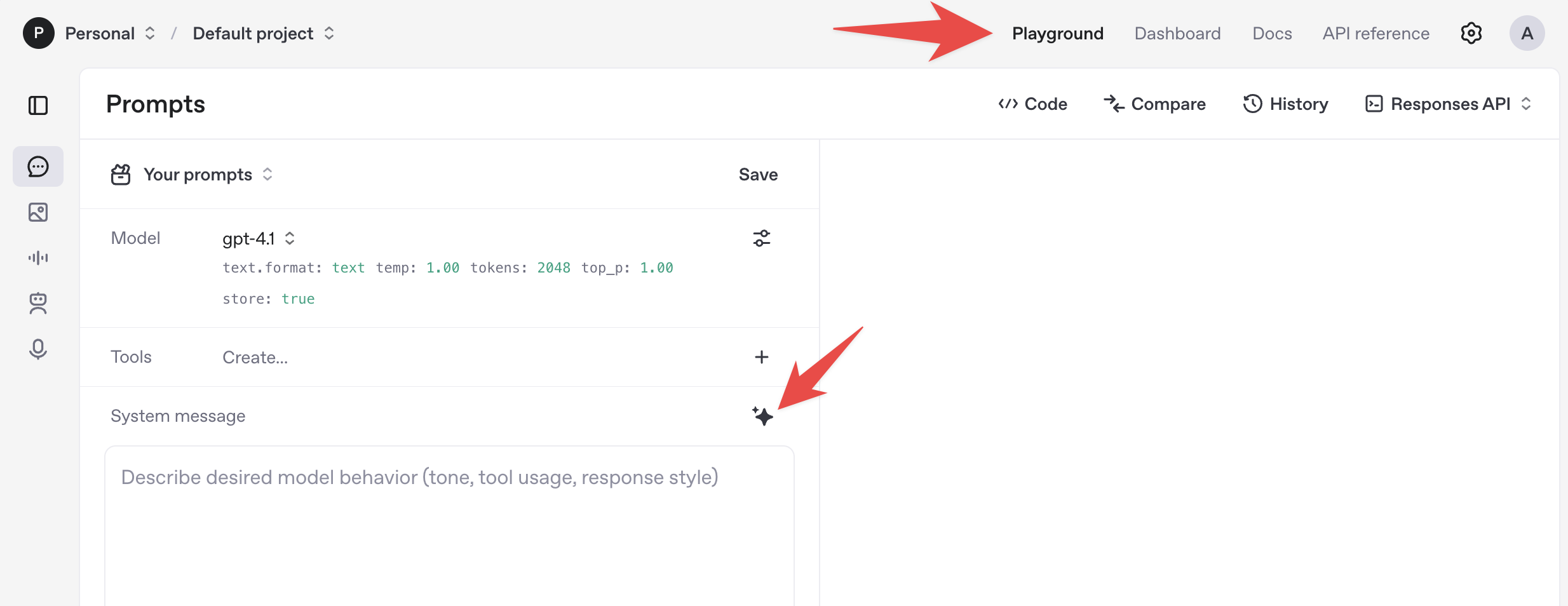

- OpenAI Playground:在实践中提炼Prompt OpenAI 的 PROMPT 生成器没有做的像 Claude 那么明显,因此可能有些朋友没有注意到。其实它就在 Playground 里面。先进入 OpenAI Playground,然后在左边 System Message 输入框的右上角,那个猛一看以为是 Gemini 的标志,就是 OpenAI 的 PROMPT 生成器。

有了这些工具,写出一个还算有水准的 PROMPT 也就不是什么难事了。

风格差异:真的会影响AI的输出效果吗?

看到这里,你可能会问:既然有这么多不同的”写法”,那是不是意味着Prompt的分区方式、定界符选择对最终结果影响不大呢?

答案是:既是,也不是。

- “不是”:分区方式本身,比如是用 XML 还是 Markdown,并不会像魔法一样凭空改变模型的核心能力。AI不会因为你用了

###就突然变得更聪明,或者因为用了<task>就突然理解了它之前不懂的概念。 - “是”:然而,一个清晰、可被模型准确解析的边界和结构,确实会显著影响 AI 理解和执行指令的准确性。它可以:

- 减少歧义。

- 降低提示注入(Prompt Injection)的风险。

- 在某些模型上带来可测量的准确率和任务遵从性提升。

事实是,不同AI厂商在训练和微调模型时,的确有其”偏爱”或侧重优化的分隔习惯。例如,Claude对 XML 标签的响应更好,而 OpenAI 的模型则更熟悉 Markdown 标记或特定分隔符(如""")。因此,采用AI”对胃口”的格式,成功率往往更高。 (参考:OpenAI Best Practices, Anthropic XML Tags)

为什么”有效分区”如此重要?

你可能会想,只要我把话说清楚了,AI不就应该能理解吗?为什么还要强调分区?

- 减少”指令”与”上下文/待处理数据”的混淆:

- 机理:像GPT系列模型,在其庞大的训练数据中,见过海量的以

"""…"""、###、Markdown 标题等符号分隔的文本。当模型在 Prompt 中遇到这些熟悉的”分隔符”时,其内部的注意力机制会更倾向于将分隔符前的内容识别为”指令区”,而将后续内容视为”待处理数据区”或”上下文区”。(来源:OpenAI Help Center)

- 机理:像GPT系列模型,在其庞大的训练数据中,见过海量的以

- 提升复杂指令的约束遵守率:

- 机理:以 Claude 为例,Anthropic 在对模型进行微调时,明确地训练模型”看到 XML 标签时,应将其内容视为独立的思考单元或指令集”。因此,使用如

<instructions>、<context>、<example_input>等标签,能显著提高模型对复杂指令的遵从度和准确性。(来源:Anthropic Docs)

- 机理:以 Claude 为例,Anthropic 在对模型进行微调时,明确地训练模型”看到 XML 标签时,应将其内容视为独立的思考单元或指令集”。因此,使用如

- 有效降低”提示注入”的风险:

- 机理:当用户输入的内容可能包含潜在的恶意指令时,通过清晰的定界符(如 XML 标签或三重引号)将用户输入严格包裹起来,可以有效地将这些潜在的恶意指令”锁”在限定的数据区域内,从而减少其干扰或覆盖主指令、造成越权执行的风险。

- 对评测分数有微幅但可观测的积极影响:

- 机理:多篇近期的研究论文通过实验证明,即使Prompt的核心内容完全相同,仅仅是排版方式、分隔符选择的不同,也可能导致模型在某些标准任务上的得分产生2-5个百分点的差异。这说明结构化对于模型性能确实有影响,但研究也同时指出,目前并不存在一种”万能普适”的最佳格式。

小结一下:Prompt中的分区和定界符,主要作用是帮助模型”更好地读懂我们到底想让它干什么”。结构越清晰,模型出错的概率就越低。当然,这并不意味着我们要过度迷信某种特定符号。只要你的自然语言指令本身足够清晰、明确、无歧义,即便换一种分隔方式,模型通常也能理解你的核心意图。

那RICE这类标准化框架还有意义吗?

既然OpenAI和Claude的自动优化Prompt有时看起来并没有严格遵循RICE(Role, Input, Context, Expectation)或其他类似的固定框架,这是否意味着我们辛辛苦苦设计的Prompt框架没有太大意义了?

并非如此!你精心设计的框架(如RICE、CRISPE等)依然非常有价值,尤其是在以下场景中:

- 自动化拼接Prompt:当你需要通过程序动态生成或组合Prompt的各个部分时,一个标准化的框架能确保信息模块的有序和完整。

- 团队协作与知识共享:在团队内部,统一的Prompt框架有助于不同成员快速理解和复用彼此的Prompt,降低沟通成本,提升协作效率。

- 版本管理与A/B测试:对于需要迭代优化和进行效果对比的Prompt,标准化的框架使得追踪变量、分析效果差异更为便捷和科学。

如果你的工作涉及到以上任何一种场景,那么坚持使用和优化你的Prompt框架绝对是值得的。反之,如果只是个人快速使用,那么采用”轻量级模板 + 具体清晰的案例”可能会更加高效。

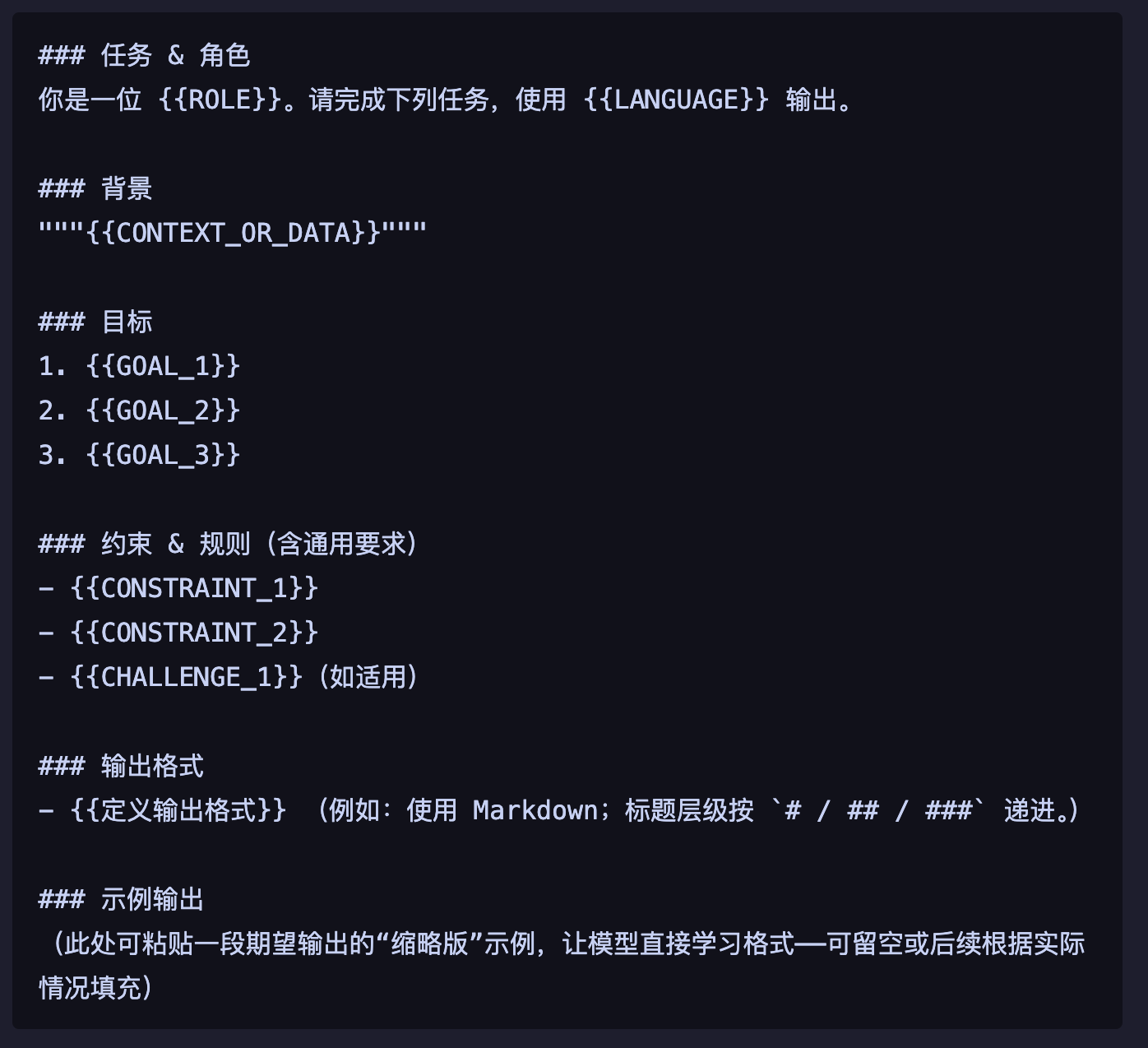

实战派分享:我的通用结构化 Prompt 模板

下面是在我的提示工程教学和实践过程中,总结并常用的通用结构化提示模板,我称之为 RCARE 模板。这个模板旨在提供一个清晰的框架,帮助系统地组织思路,特别是在处理需要明确角色、上下文、目标和关键约束的复杂任务时,确保向 AI 传递全面的指引。

这个模板更像一个快速检查清单和思考辅助工具,帮助我们系统地梳理核心需求,确保向 AI 传递关键的指引和约束。

RCARE 提示模板示例:

如何理解和使用RCARE模板?

- 全面性与结构性:此模板提供了一个相对全面的结构,覆盖了复杂任务中的多个关键方面——角色、语言、具体背景、明确目标、核心约束以及可选的示例。它鼓励用户系统性地思考这些要素。

- 灵活性与适应性:占位符

{{PLACEHOLDER}}的设计使得模板易于填充和定制。"""{{CONTEXT_OR_DATA}}"""中的三引号适合粘贴较长的背景材料。 - 目标驱动:明确列出多个目标有助于 AI 理解任务的多个方面或期望达成的多重效果。

- 风险预估:包含”约束 & 难点”有助于提前思考并告知 AI 潜在的限制和挑战。

- 迭代起点:这是一个很好的起点。在实际使用中,你可以根据AI的反馈和输出质量,增删或调整模板中的部分,例如,如果发现AI对任务步骤理解不清,可以在”目标”之后或之内补充更详细的”执行步骤”。

通过这样一个我常用的通用结构化模板,我们可以系统地组织思路,构建出相对复杂的提示,并为后续的迭代优化打下良好基础。

我的「AI 实战派」课程,我认为依然是最好的提示工程课程,从基础理念到高级技巧,再到实战案例,助你全面掌握与AI高效协作的秘诀。如果你还不是我的学员,欢迎点击链接了解 或者在浏览器直接中输入 axtonliu.ai

高级技巧:当Markdown遇上 ### —— 如何避免模型混淆?

这篇文章解决了你的一个“点”

但真正的竞争力,来自于将无数个“点”连接成“系统”的能力。旗舰课程 MAPS™ 训练营 专为此而设,带你从解决零散问题,到构建一个能为你持续创造价值的AI强大引擎。

AI 越强,"工程"两个字越值钱 | AI 精英周刊 036

AI 越强,"工程"两个字越值钱 | AI 精英周刊 036

AI 编排时代:Opus 4.6 多 Agent 协作、Karpathy 终结 Vibe Coding |AI 精英周刊 035

AI 编排时代:Opus 4.6 多 Agent 协作、Karpathy 终结 Vibe Coding |AI 精英周刊 035

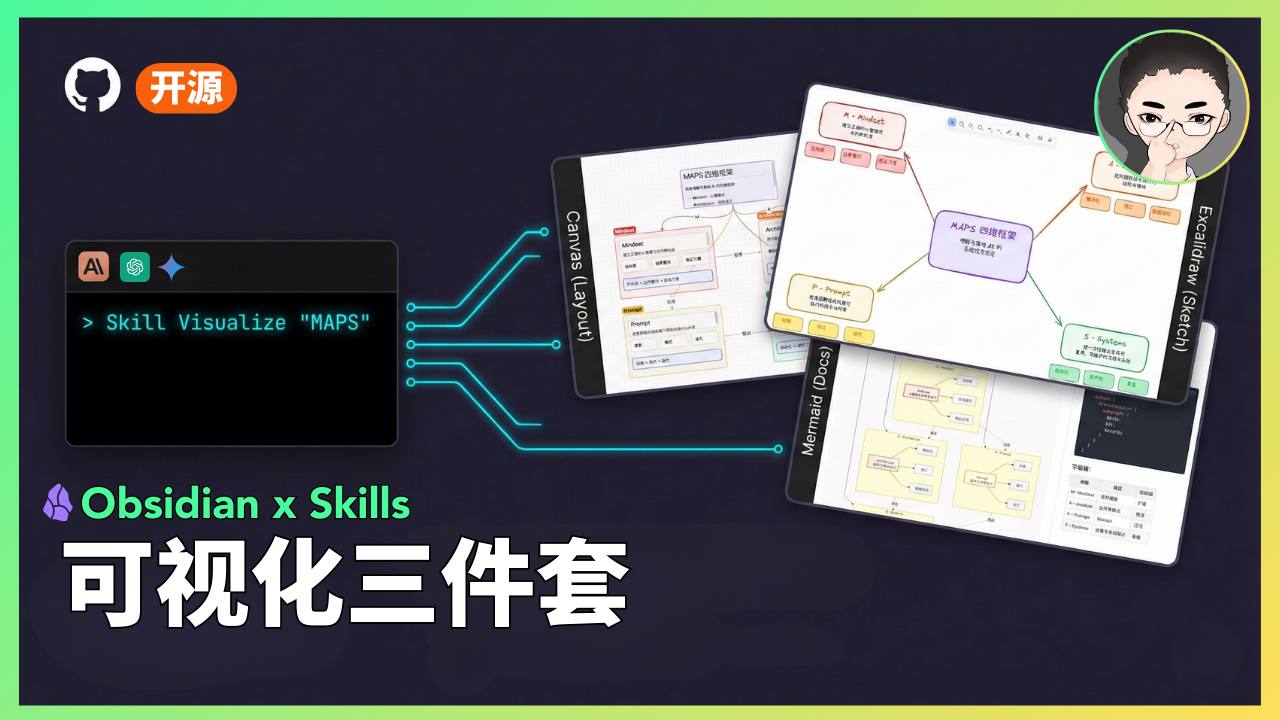

同一段内容,三种图:Obsidian 可视化三件套 Skills 完全开源| AI 精英周刊 034

同一段内容,三种图:Obsidian 可视化三件套 Skills 完全开源| AI 精英周刊 034